Какой главный критерий вы указываете копирайтеру при написании статьи для вашего сайта? Правильно. Уникальность не ниже 90%. Кто-то даже просит 100%, но это как-то уж совсем слишком. Давайте разберемся, насколько важна уникальность контента, а также найдем, что об этом думают признанные гуру мирового интернет-маректинга.

Нил Патель и его коллеги считают, что вокруг неоригинального контента слишком много мифов

Нил Патель — это гуру поискового маркетинга на западе. У него даже есть страничка на википедии, но наибольшую популярность он получил за свой блог, который, по его словам, читают тысячи людей ежедневно.

В блоге Нила есть статьи почти по любому вопросу интернет-маркетинга, в том числе есть и статья с тремя мифами о дублирующемся контенте. Ее написал не сам Нил, но он абы что на своем сайте не опубликует.

Миф номер один нам не слишком интересен, он о том, что неоригинальный контент на одной из страниц навредит всему сайту. Думаю, что современные веб-разработчики и так прекрасно понимают, что тогда поисковики наложили бы санкции на половину интернета.

Автор тоже не особо заостряет на этом мифе свое внимание и рассказывает историю, как в одном из его проектов домашняя страница была полностью "скопипащена" в пресс-релиз, который затем был мгновенно опубликован по всему интернету. За это на сайт наложили ручные санкции (в том числе и потому, что домен был создан совсем недавно), но тут фирма сама виновата.

В современных реалиях такое почти невозможно. Ваш домен, скорее всего, существует уже какое-то время, поэтому даже при таком сценарии массового копирования поисковик просто проигнорирует подобный спам. А если вас будут копировать время от времени, как это обычно и происходит, санкции практически невозможны.

Второй миф касается автоматических парсеров сайтов. Может показаться, что автоматическое копирование вашего контента и размещение на разных площадках тоже может как-то навредить, но автор статьи парирует.

Парсеры не помогают и не вредят. Неужели вы думаете, что какой-то небольшой блог где-то в Азии, у которого вообще нет оригинального контента и трафика, как-то влияет на алгоритмы Гугла? Нет, он просто игнорируется поисковиком.

В статье отмечено, что все-таки небольшую пользу от парсеров извлечь можно. Они обычно копируют статьи "как есть": со всеми ссылками, оформлением. Поэтому при неплохой перелинковке в скопированной статье есть шанс получить переход от случайно забредшего на их сайт посетителя.

Но на сайты, которые вдруг (редко) оказались выше вас в поиске, пожаловаться поисковику все же можно.

Следует отличать парсеров контента от тех, кто просто ворует ваш контент. Если вы заметили, что какой-то сайт полностью скопировал ваше оформление и еще и контент ваш использовал, тут уже нужно жаловаться не поисковику, а идти к юристам, если вы конечно зарегистрировали права на товарный знак.

Третий миф больше касается гостевого блоггинга. В статье два совета:

- Можно сделать гостевой пост на чужом сайте, а потом разместить еще и на своем, но тогда нужно обязательно добавить специальный тег с атрибутом canonical типа.

- Можно использовать тактику написания похожего контента, но как бы наоборот. Например, не с "советами о том, как приготовить курицу в духовке", которые вы дали на страницах другого ресурса, а с "типичными ошибками тех, кто готовит курицу в духовке", но уже на своем. Конечно, примеры в статье нужно тоже отзеркалить, а весь текст переписать, но сделать это гораздо проще, ведь вы уже писали похожий контент.

<link rel="canonical" href="https:://www.blog.com/original-article"/>

А вот самый полезный совет дан в конце статьи. Звучит просто:

"Люди, расслабьтесь."

Совет сводится к тому, что не нужно думать, что поисковик настолько глуп, чтобы индексировать все подряд. Туда хантят лучших программистов, которые постоянно работают над изменением алгоритмов поиска. Вряд ли они настраивают его таким образом, чтобы он автоматом накладывал санкции на сайты, где есть неуникальный контент. Скорее всего, логика поискового робота примерно такая: робот обходит множество сайтов в день, если он находит скопированный контент какое-то время спустя, он "помнит", где он индексировал его первый раз, поэтому просто продолжает сканировать сайт, не накладывая никаких санкций.

Агентство TexTerra вообще считает, что уникальность контента — главный SEO-миф

Статью про уникальность для блога агентства написал ее руководитель (хм, и эту тоже написал руководитель, ну да ладно) еще в 2015 году, но ее до сих пор яростно комментируют.

Статья написана в хорошем таком жанре личного дневника, поэтому я ее подсушу и выдерну самое главное. Итак, главная мысль такая:

Я же утверждаю, что сама по себе уникальность текста, если рассматривать ее в отрыве от реальных показателей сайта, на котором этот текст опубликован, не имеет никакой ценности для поиска. Я утверждаю, что для поиска важна не уникальность как таковая, а востребованность текста аудиторией. Другими словами, если текст никому не нужен «здесь и сейчас», то никакая уникальность не поможет.

Денис считает, что высокая уникальность превратилась в некий культ, а ее низким показателем можно объяснить любые проблемы сайта. Чтобы аргументировать свои выводы, он приводит в пример типы сайтов, на которых высокая уникальность не играет роли, а также указывает на случаи, когда высоких показателей уникальности вообще невозможно добиться:

- Интернет-магазины (а именно карточки товаров). Пойди попробуй переписать характеристики телефонов так, чтобы уникальность была не ниже 90%. Это нереально и ненужно. И поисковики это прекрасно понимают.

- Новостные сайты. Если у таких сайтов есть постоянная армия читателей (аудитория), то перепечатка с указанием источника не приведет ни к чему плохому, но при условии, что есть и свои материалы.

- Любая аналитическая статья. Если вы пишете аналитическую статью и претендуете с помощью нее на некую экспертность, в ней обязательно должны быть ссылки на источники и цитаты специалистов. Каким образом тогда добиться нужных цифр уникальности, если цитаты исправлять не принято? Неизвестно.

После изучения комментариев к статье Денис еще раз подчеркнул, сославшись на интервью со специалистом Гугла, что в статье важна не уникальность текста, а сама востребованность материала. Если материал полезный, то и ранжироваться он будет высоко.

Итак, наши примеры низкой уникальности текста и высоких позиций в поиске

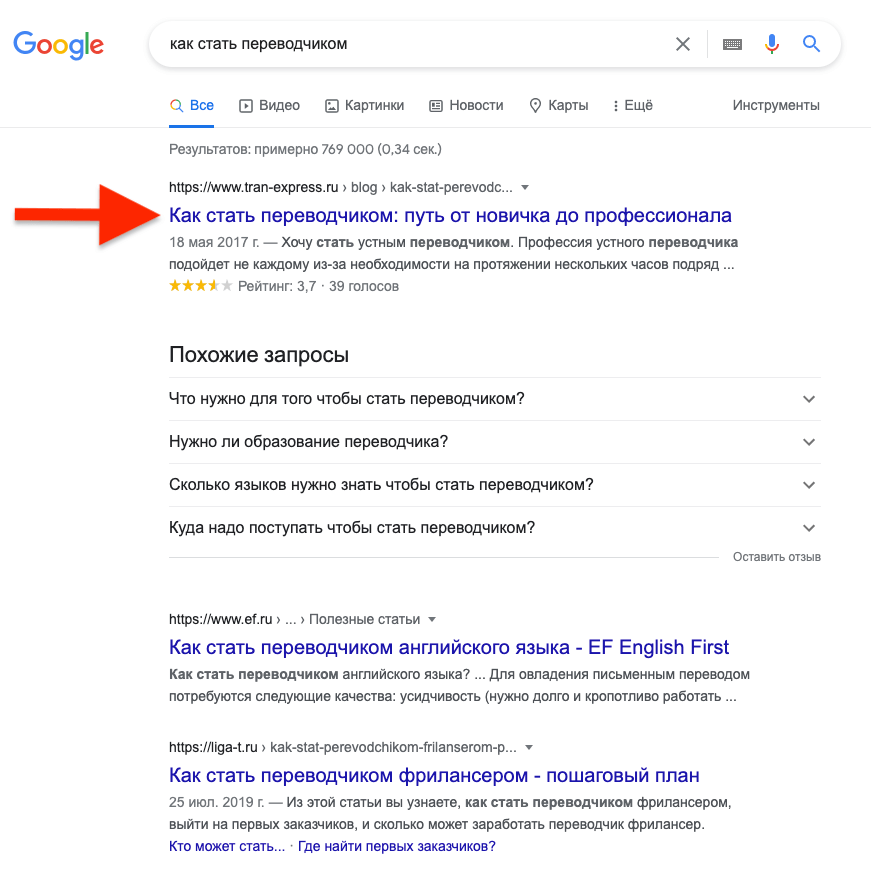

Мы помогаем одному бюро переводов писать классные статьи. Статья про то, как стать переводчиком, находится в топе как в яндексе, так и в гугле с уникальностью менее 3%, потому что ее не перепечатал и не скопипастил только ленивый

Статья занимаем первую позицию в гугле

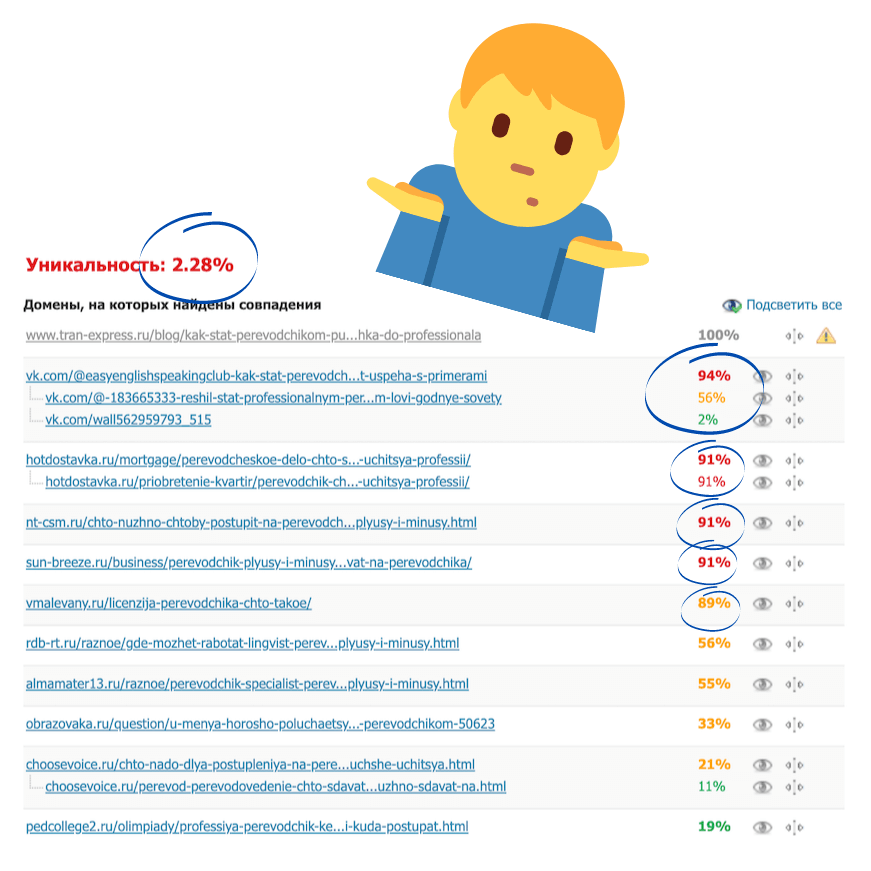

Уникальность 2.28% и куча копипастов

Думаем, что и с другими статьями, по которым есть хороший трафик, примерно такая же ситуация с уникальностью.

Что делать? Так ведь ничего, наслаждаться первой позицией в поиске.

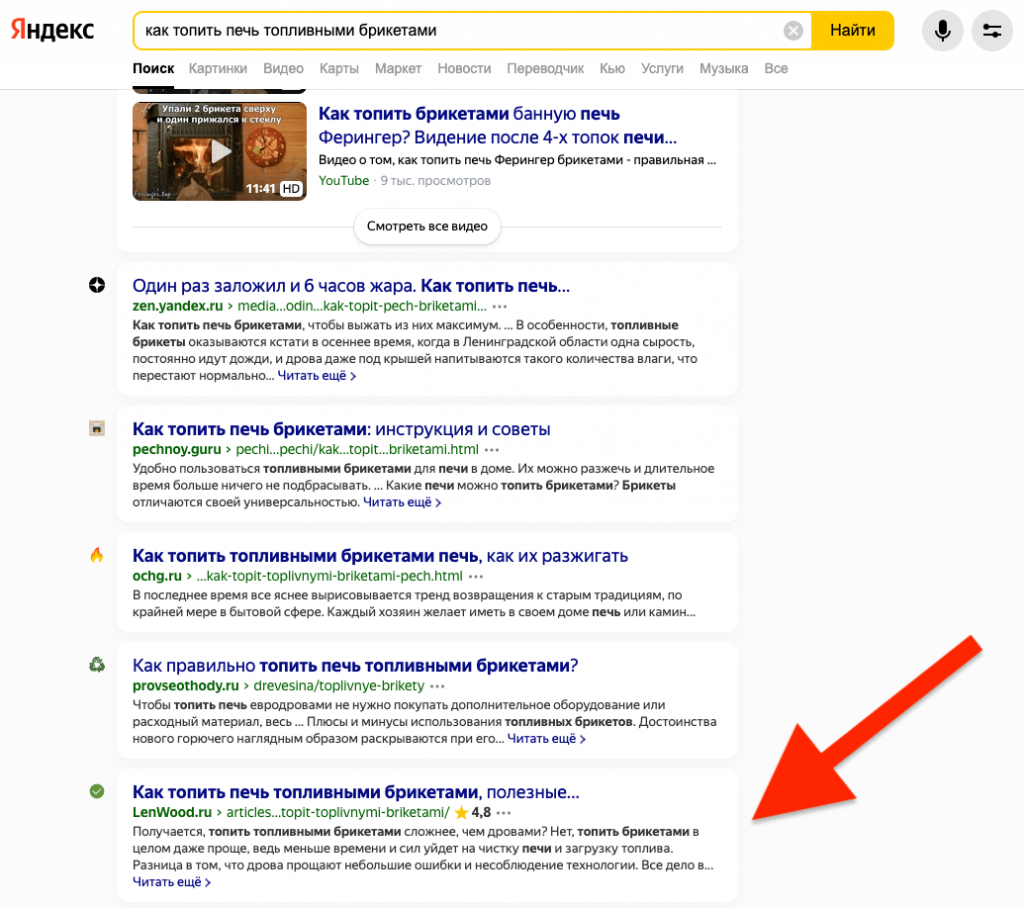

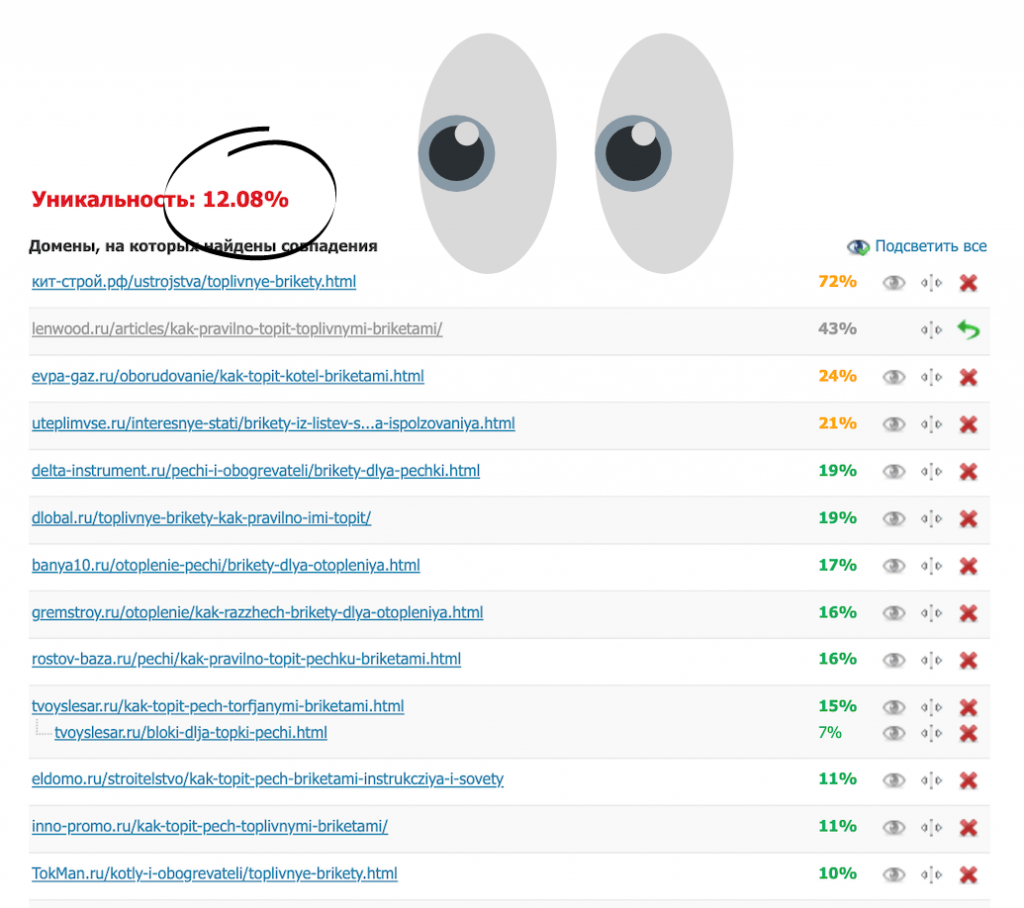

А магазину пиломатериалов мы написали статью с советами по топке топливными брикетами, которая тоже находится в топе как в яндексе, так и в гугле с уникальностью 12%.

Статья занимаем пятую позицию в яндексе

Уникальность 12%, но главный копипастер не выше в поиске

И мы более чем уверены, что в ближайшем будущем ее уникальность снизится, потому что ее расшарят и скопируют еще, но вряд ли это как-то повлияет на позиции.

Итак, сделаем и мы хороший вывод, чтобы нас растащили по интернету.

Если вы написали реально классную статью, ее неизбежно скопируют и разместят на форумах, в соцсетях, у себя на сайте. И вы ничего не сможете сделать, чтобы защититься от этого.

Да и не нужно ничего делать. Наслаждайтесь тем, что ваш контент оказался настолько крут, что его хотят разобрать на цитаты, и пишите еще больше полезного материала.